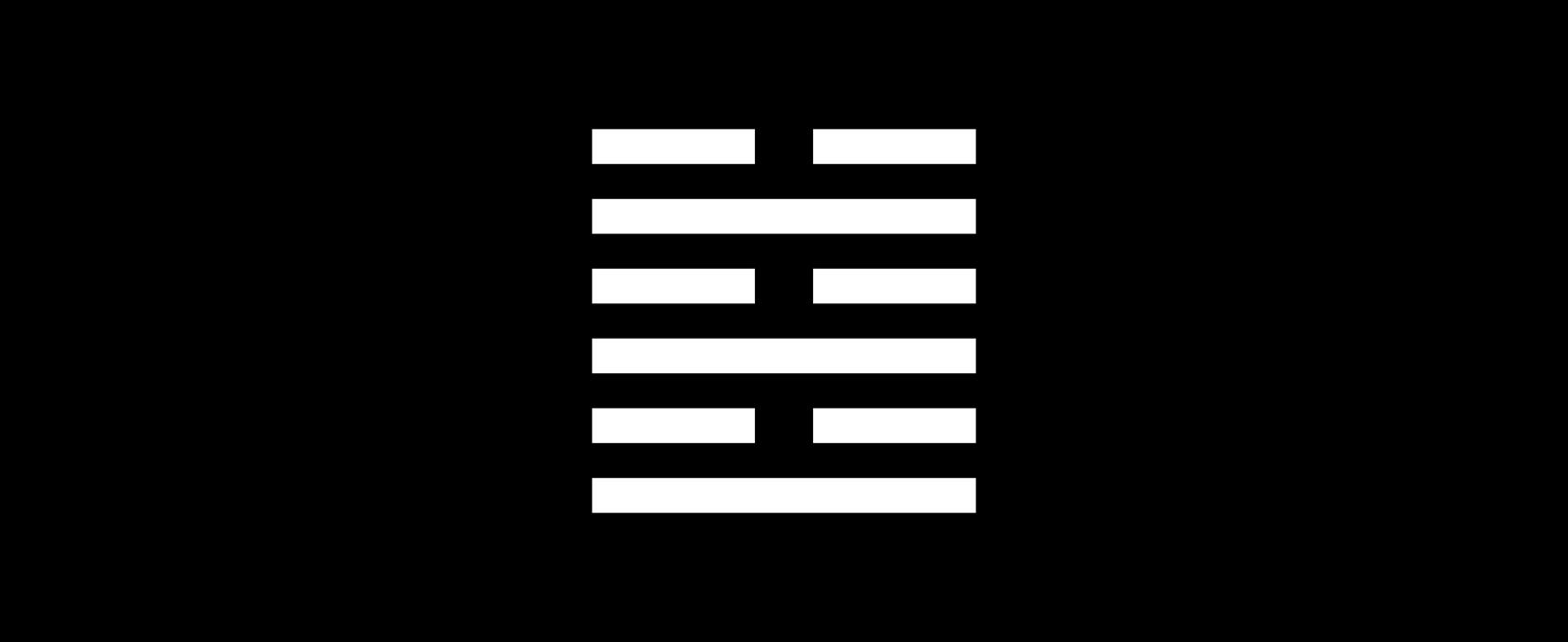

Il compimento

Prima del compimento

In questo segno è indicato il momento in cui il passaggio dal disordine all’ordine non è ancora compiuto. In verità il cambiamento è già preparato perché tutte le linee del trigramma superiore stanno in rapporto con quelle dell’inferiore. Ma esse non sono ancora al loro posto. Prima del compimento. Riuscita.

Le condizioni sono difficili. Il compito è grande e pieno di responsabilità. Si tratta addirittura di ricondurre il mondo dallo scompiglio all’ordine.

Dopo il compimento

Proprio quando si è raggiunto l’equilibrio perfetto, ogni movimento può turbare l’ordine e provocare un ritorno alla disgregazione.

Nei tempi che seguono un grande passaggio tutto incalza veloce tendendo verso il progresso e lo sviluppo. Ma questo iniziale spingersi avanti non è bene e conduce sicuramente a perdita e crollo perché nella foga si oltrepassa la meta. Un carattere forte non si lascia quindi contagiare da questa ebbrezza generale, ma frena per tempo la sua corsa. Così non rimarrà del tutto immune dalle conseguenze sciagurate della generale smania di progresso, ma è colpito solo da dietro come una volpe che abbia attraversato l’acqua e vi finisca solo con la coda.

I Ching – Il libro dei mutamenti

Forse mi ingannano la vecchiezza e la paura

“La scrittura metodica mi distrae dall’attuale condizione degli uomini. La certezza che tutto questo sta scritto ci annulla o ci confonde. Conosco distretti in cui i giovani si prosternano di fronte ai libri e baciano con barbarie le pagine con brutalità, anche se non ne sanno leggere una sola lettera. Le epidemie, le discordie eretiche, le peregrinazioni che inevitabilmente degenerano in banditismo, hanno decimato la popolazione. Credo di aver già detto dei suicidi, ogni anno più frequenti. Forse mi ingannano la vecchiezza e la paura, ma sospetto che la specie umana stia per estinguersi, e che la biblioteca perdurerà: illuminata, solitaria, infinita, perfettamente immobile, armata di volumi preziosi, inutile incorruttibile, segreta.” (Borges, La biblioteca de Babel)

In questo racconto che Borges pubblicò nel 1941, c’è tutto il nostro presente: la disintegrazione della civiltà umana, il fanatismo religioso di giovani che baciano le pagine del libro che non sanno neppure leggere, le epidemie, le discordie, le migrazioni che degenerano in banditismo e decimano la popolazione. E per finire i suicidi, ogni anno più frequenti.

Una buona descrizione del terzo decennio del secolo XXI. Infine Borges annuncia che la Biblioteca non è destinata a scomparire con il genere umano: essa rimane, solitaria, infinita segreta e perfettamente inutile. Dunque la biblioteca immensa dei dati registrati da sensori visuali sonori e grafici inseriti in ogni anfratto del pianeta continuerà per sempre ad alimentare l’automa cognitivo che sta prendendo il posto degli organismi umani fragili, avvelenati dai miasmi, dementi fino al suicidio? Così dice Borges, chissà.

Durante l’epoca moderna, come aveva preconizzato Francis Bacon, la conoscenza è stata un fattore di potere sulla natura e sugli sfruttati, ma da un certo momento in poi l’espandersi del sapere tecnico ha cominciato a funzionare all’incontrario: non più protesi della potenza umana, la tecnica si è trasformata in sistema dotato di una dinamica indipendente entro la quale ci troviamo intrappolati.

Già negli anni Sessanta Gunther Anders aveva detto che la potenza della tecnologia nucleare pone la società in una condizione di impotenza. Gli Stati dotati dell’arma nucleare possono sempre meno sottrarsi alla logica della competizione che spinge a un’estensione e a un perfezionamento sempre più distruttivo della tecnologia atomica, fino al punto che questa può sfuggire alla stessa volontà di chi l’ha concepita e sviluppata.

In questa superiorità funzionale dell’arma atomica Anders vede le condizioni di una nuova e più compiuta forma di nazismo.

Nel nuovo secolo le tecnologie digitali hanno creato le condizioni per l’automazione dell’interazione sociale, fino al punto di rendere inoperante la volontà collettiva.

Nel 1993, in Out of control, Kevin Kelly aveva previsto che le allora nascenti reti digitali avrebbero creato una Mente Globale cui le menti sub-globali (individuali o collettive o istituzionali) avrebbero forzosamente dovuto sottomettersi.

Intanto si andava sviluppando la ricerca sull’intelligenza artificiale o AI, che oggi ha raggiunto un livello di maturità sufficiente a prefigurare l’iscrizione nel corpo sociale di un sistema di concatenazione di innumerevoli congegni capaci di rendere automatiche le interazioni cognitive umane. L’ordine logico si inscrive nei flussi stessi della riproduzione sociale, ma questo non significa che il corpo sociale ne venga armonicamente regolamentato. La società planetaria è sempre più innervata di automatismi tecnici, ma questo non elimina affatto la conflittualità, la violenza, la sofferenza. Nessuna armonia è in vista, nessun ordine sembra instaurarsi sul pianeta. Il caos e l’automa convivono intrecciandosi e alimentandosi a vicenda. Il caos alimenta la creazione di interfacce tecniche di controllo automatico, che solo rendono possibile il proseguimento della produzione di valore. Ma la proliferazione di automatismi tecnici, impugnati dalle innumerevoli agenzie di potere economico, politico e militare in conflitto finisce per alimentare il caos, piuttosto che ridurlo.

Si stanno svolgendo due storie del mondo parallele, con punti di intersezione ubiqui, ma pur sempre separate: la storia del caos geopolitico psichico ambientale, e la storia dell’ordine automatico che si concatena estensivamente.

Ma sarà sempre così oppure ci sarà un cortocircuito, e il caos si impadronirà dell’automa? O piuttosto l’automa riuscirà a liberarsi del caos, eliminando l’agente umano?

L’attuale stadio di sviluppo dell’AI sta probabilmente portandoci sulla soglia di un salto alla dimensione che definirei Automa cognitivo globale pervasivo. L’automa non è un analogo dell’organismo umano, ma la convergenza di innumerevoli dispositivi generati da intelligenze artificiali disseminate.

Il compimento

Nelle ultime pagine del romanzo di Dave Eggers Il cerchio, Ty Gospodinov confessa a Mae la sua impotenza di fronte alla creatura da lui stesso concepita e costruita, la mostruosa impresa tecnologica costituita da una convergenza tra Facebook, Google, PayPal, YouTube e molto altro. Non volevo che accadesse quello che sta accadendo, dice Ty Gospodinov, ma ora non posso più fermarlo.

All’orizzonte del romanzo si staglia il Compimento (Completion), il chiudersi del cerchio: tecnologie di capillare raccolta dati e intelligenze artificiali si connettono perfettamente in una rete ubiqua di generazione sintetica della realtà condivisa.

L’attuale stadio di sviluppo dell’AI sta probabilmente portandoci sulla soglia di un salto alla dimensione che definirei Automa cognitivo globale pervasivo. L’automa non è un analogo dell’organismo umano, ma la convergenza di innumerevoli dispositivi generati da intelligenze artificiali disseminate. L’evoluzione dell’intelligenza artificiale non porta alla creazione di androidi, alla simulazione perfetta dell’organismo cosciente, ma si manifesta come sostituzione di competenze specifiche con automi pseudo-cognitivi che si concatenano tra loro, convergendo nell’Automa cognitivo globale.

Il 28 marzo 2023 Elon Musk, Steve Wozniak, seguiti da più di mille alti funzionari del complesso high-tech tra cui Evan Sharp di Pinterest e Chris Larson della cryptocurrency company Ripple hanno sottoscritto una lettera in cui proponevano una moratoria della ricerca nel campo dell’open AI: “I sistemi di AI stanno diventando competitivi con l’uomo nel perseguire scopi generali, e dobbiamo chiederci se dobbiamo permettere che delle macchine invadano i nostri canali di informazione con propaganda e falsità. Dovremmo permettere che vengano automatizzate tutte le attività lavorative comprese quelle gratificanti? Dovremmo sviluppare menti non umane che potrebbero superarci per numero e per efficacia, così da renderci obsoleti e sostituirci? Dovremmo rischiare di perdere il controllo sulla nostra civiltà? Queste decisioni non possono essere delegate ai leader non eletti della tecnologia. Questi potenti sistemi di intelligenza artificiale si dovrebbero sviluppare solo quando saremo fiduciosi del fatto che i loro effetti saranno positivi e i loro rischi saranno gestibili. Perciò ci rivolgiamo a tutti i laboratori di AI perché sospendano immediatamente e per almeno sei mesi l’addestramento di sistemi di AI più potenti del GPT-4. Questa pausa dovrebbe essere pubblica e verificabile, e dovrebbe comprendere tutti gli attori decisivi. Se non si mette in opera una pausa di questo genere i governi dovrebbero prendere l’iniziativa di imporre una moratoria.”

Poi, all’inizio del maggio 2023, si diffonde la notizia che Geoffrey Hinton, uno dei primi creatori di reti neurali, ha deciso di lasciare Google per potersi esprimere apertamente sui pericoli impliciti nell’intelligenza artificiale: “Alcuni dei pericoli dei chatbot dotati di intelligenza artificiale sono abbastanza spaventosi”, ha detto Hinton alla BBC, perché possono diventare più intelligenti degli umani e possono essere utilizzati da degli agenti malintenzionati. Oltre a prevedere la possibilità di manipolazione dell’informazione, quel che preoccupa Hinton è “il rischio esistenziale che si presenterà quando questi programmi saranno più intelligenti di noi […]. Sono giunto alla conclusione che il tipo di intelligenza che stiamo sviluppando sia molto differente dall’intelligenza che abbiamo […], come ritrovarsi 10.000 persone diverse e ogni volta che una di queste persone viene a conoscenza di qualcosa, tutte le altro vengono automaticamente a saperlo”.

L’avanguardia ideologica e imprenditoriale del neoliberismo digitale sembra spaventata dalla potenza del Golem, e quali apprendisti stregoni, gli imprenditori dell’alta tecnologia chiedono una moratoria, una pausa, un periodo di riflessione.

Ma come? La mano invisibile non funziona più? L’autoregolazione del Capitale-Rete non è più all’ordine del giorno?

Cosa sta accadendo? Cosa sta per accadere? Cosa sta per poter accadere?

Sono tre domande distinte; cosa sta accadendo più o meno lo sappiamo: grazie alla convergenza tra raccolta massiccia di dati, programmi capaci di riconoscimento e di ricombinazione, e dispositivi di generazione, sta emergendo una tecnologia capace di simulare specifiche competenze intelligenti – pappagalli stocastici.

Quel che sta per accadere è che i pappagalli stocastici, grazie alla capacità di autocorrezione e alla loro capacità di scrivere software evolutivo sono destinati ad accelerare enormemente l’innovazione tecnica – in particolare l’innovazione tecnica di se stessi.

Quel che potrebbe accadere e accadrà molto probabilmente: dispositivi di autocorrezione innovativa (deep learning) determinano le loro finalità in modo indipendente dal creatore umano. Nella morsa della competizione economica e militare le ricerche e l’innovazione non si possono sospendere, soprattutto se pensiamo all’applicazione dell’AI in campo militare. Credo che gli apprendisti stregoni si stiano rendendo conto del fatto che l’autonomia tendenziale dei generatori linguistici (autonomia dal creatore umano) è implicita nella loro capacità di simulare una competenza intelligente in modo più efficiente dell’agente umano, sia pure in un campo specifico e limitato. Tendenzialmente le competenze specifiche convergeranno verso la concatenazione di automi autodiretti per i quali l’originario creatore umano potrebbe divenire un ostacolo da eliminare.

Nel dibattito giornalistico su questo tema prevalgono posizioni di cautela: si segnalano problemi come diffusione di notizie false, incitamenti all’odio o implicite dichiarazioni razziste. Tutto vero, ma non molto rilevante. Sono anni che le innovazioni di tecnologia comunicativa incrementano la violenza verbale e l’idiozia. Non può essere questo che preoccupa i padroni dell’automa, coloro che lo hanno concepito e lo stanno implementando. Quel che preoccupa gli apprendisti stregoni, a mio parere modestissimo, è la consapevolezza che l’automa intelligente dotato di capacità di autocorrezione e di autoapprendimento è destinato a prendere decisioni autonome dal suo creatore.

Pensiamo ad un automatismo intelligente inserito nel congegno di controllo su un dispositivo militare. Fino a che punto si può star certi che esso non si evolva in maniera imprevista, finendo magari per sparare al suo proprietario o per dedurre logicamente dai dati informativi cui può avere accesso l’urgenza di lanciare la bomba atomica?

Questa superiorità (o piuttosto irriducibilità alla computazione) del pensiero umano è una magra consolazione, perché essa non serve a molto quando si tratta di interagire con dispositivi di generazione (e di distruzione) basati sul calcolo.

Linguaggio generativo e pensiero: il cervello senza organi

La macchina linguistica che risponde alle domande è una dimostrazione del fatto che Chomsky ha ragione quando dice che il linguaggio è il prodotto di strutture grammaticali inscritte nel corredo biologico umano, dotate di carattere generativo, cioè capaci di generare infinite sequenze dotate di significato. Ma il limite del discorso chomskiano sta proprio nel rifiuto di vedere il carattere pragmatico dell’interpretazione dei segni di linguaggio; similmente, il limite del chatbot GPT consiste proprio nella sua impossibilità di leggere pragmaticamente le intenzioni di senso.

In un libro dal titolo La ricerca della lingua perfetta Umberto Eco dice che “Una lingua naturale non vive solo basandosi su una sintattica e una semantica. Vive anche sulla base di una pragmatica, ovvero si basa su regole d’uso che tengono conto delle circostanze e dei contesti di emissione, e queste stesse regole d’uso stabiliscono la possibilità degli usi retorici della lingua grazie ai quali parte e costruzioni sintattiche possono acquisire significati multipli (come avviene con le metafore).” (Eco: 1993, pag. 30).

Generative pre-trained transformer (GPT) è un programma capace di rispondere e dialogare con un umano grazie alla capacità di ricombinare parole, frasi e immagini recuperate dalla rete linguistica oggettivata nell’Internet. Il programma generativo è stato addestrato a riconoscere il significato delle parole e delle immagini, e possiede la capacità di organizzazione sintattica degli enunciati. Esso possiede la capacità di riconoscere e ricombinare il contesto sintattico, ma non il contesto pragmatico, cioè il vivente intensivo nel processo della comunicazione, perché questa capacità dipende dall’esperienza di un corpo, e questa esperienza non è alla portata di un cervello senza organi, quale è ogni intelligenza artificiale. Gli organi sensibili costituiscono una fonte di conoscenza contestuale e autoriflessiva di cui l’automa non dispone.

L’automa è capace di intelligenza, non di pensiero. L’automa è superiore all’umano nel campo del calcolabile, ma il pensiero è proprio incursione del non calcolabile (coscienza/inconscio) nella conoscenza e nel ragionamento. Ma questa superiorità (o piuttosto irriducibilità alla computazione) del pensiero umano è una magra consolazione, perché essa non serve a molto quando si tratta di interagire con dispositivi di generazione (e di distruzione) basati sul calcolo.

Dal punto di vista dell’esperienza l’automa non compete con l’organismo cosciente. Ma in termini di funzionalità l’automa (pseudo)cognitivo è in grado di superare in efficienza (outsmart) l’agente umano in una competenza specifica (calcolare, fare liste, tradurre, prendere la mira, sparare e così via). L’automa è inoltre dotato della capacità di perfezionare le sue procedure, cioè di evolvere. Detto altrimenti, l’automa cognitivo tende a modificare le finalità del suo operare, non solo le procedure.

Nella sfera umana il linguaggio è costituito da segni che significano entro un contesto esperienziale. Grazie all’interpretazione pragmatica del contesto diviene possibile l’interpretazione semantica dei segni (sia quelli naturali che quelli linguistici, dotati di intenzione). La congiunzione tra corpi è il contesto non verbale entro il quale si rende possibile l’individuazione e la disambiguazione del significato degli enunciati.

Nella sfera congiuntiva il rapporto con la realtà si fonda sulla capacità del linguaggio di rappresentare e di persuadere.

Nella sfera connettiva l’interpretazione dei segni non ha il carattere dell’esperienza in contesto ambiguo, ma del riconoscimento in contesto di esattezza.

L’intelligenza linguistica artificiale è costituita da un software capace di riconoscere serie semiotiche sintatticamente coerenti, e anche di generare enunciati attraverso la ricombinazione sintatticamente coerente di unità significanti.

Da quando si sono sviluppate capacità di self-learning, l’automa è in condizione di prendere decisioni relative al perfezionamento delle procedure, ma anche, tendenzialmente, di prendere decisioni relative alle finalità stesse dell’operare automatico. I dispositivi tecno-linguistici che incorporano software di Intelligenza artificiale non si limitano infatti ad eseguire programmi generativi, ma possono scrivere questi programmi, possono evolversi in quanto sono dotati di tecniche destinate all’apprendimento: machine learning.

Grazie all’evoluzione dei pappagalli stocastici in agenti linguistici capaci di autocorrezione evolutiva, il linguaggio, reso capace di autogenerazione, si fa autonomo dall’agente umano, e l’agente umano viene progressivamente involucrato nel linguaggio.

Non sussunto, ma involucrato, incapsulato. La piena sussunzione implicherebbe una pacificazione dell’umano, un’acquiescenza compiuta: un Ordine, alfine.

Alfine un’Armonia, sia pur totalitaria.

Invece no. La guerra predomina nel panorama planetario.

In questo neo-ambiente dell’automa linguistico in concatenazione, gli agenti umani devono perfezionare le loro competenze connettive, mentre la capacità congiuntiva si affievolisce e il corpo sociale si irrigidisce, si fa aggressivo.

L’evoluzione delle macchine le rende sempre più capaci di simulare l’umano. Ma l’evoluzione umana consiste nel rendersi compatibile con la macchina. In questo adattamento la mutazione cognitiva rende l’agente umano più efficiente nell’interazione con la macchina, ma al tempo stesso meno competente nell’interazione comunicativa con l’altro agente umano.

Il progetto di inserire regole etiche nella macchina generativa è una vecchia utopia della fantascienza, su cui per primo scrisse Isaac Asimov, quando formulò le tre leggi fondamentali della robotica. Lo stesso Asimov dimostra narrativamente che queste leggi non funzionano.

L’automa etico è un’illusione

Quando gli apprendisti stregoni si sono resi conto delle possibili implicazioni della capacità autocorrettiva e quindi evolutiva dell’intelligenza artificiale, si è cominciato a parlare di etica dell’automa, o di allineamento, come si dice nel gergo filosofico imprenditoriale.

Nella loro pomposa presentazione, gli autori del chatbot GPT dichiarano che è loro intenzione iscrivere nei loro prodotti criteri etici allineati con i valori etici umani: “La nostra ricerca di allineamento mira a rendere l’intelligenza artificiale generale allineata con i valori umani e le intenzioni umane”.

Ma il progetto di inserire regole etiche nella macchina generativa è una vecchia utopia della fantascienza, su cui per primo scrisse Isaac Asimov, quando formulò le tre leggi fondamentali della robotica. Lo stesso Asimov dimostra narrativamente che queste leggi non funzionano.

E del resto quali norme etiche dovremmo inserire nell’intelligenza artificiale? L’esperienza di secoli mostra che un accordo universale sulle regole etiche è impossibile dal momento che i criteri di valutazione etica sono relativi ai contesti culturali, religiosi, politici, e anche ai contesti pragmatici imprevedibili dell’azione. Non esiste un’etica universale, se non quella imposta dal dominio occidentale che però comincia a scricchiolare.

Ovviamente ogni progetto di intelligenza artificiale porterà inscritti criteri che corrispondono a una visione del mondo, a una cosmologia, a un interesse economico a un sistema di valori in conflitto con altri. Ciascuno naturalmente pretenderà all’universalità.

“Norbert Wiener aveva osservato, già nel 1960, che faremmo meglio a essere più sicuri che lo scopo introdotto nella macchina sia lo scopo che noi realmente desideriamo. Il commento di Wiener coglie il cosiddetto problema di allineamento dei valori nell’IA, ossia la difficoltà per i programmatori di assicurare che i valori dei loro sistemi si allineino con quelli umani. Ma quali sono i valori umani? Ha senso presumere che esistano valori universali comuni all’intera società?” (Melanie Mitchell, L’ntelligenza artificiale, Einaudi, 2022, pag. 124-5).

Quel che accade in fatto di allineamento è il contrario di quel che viene promesso dai costruttori dell’automa: non è la macchina che si allinea ai valori umani, che nessuno sa bene quali siano. Ma gli umani si devono allineare con i valori automatici dell’artefatto intelligente, che si tratti di assimilare le procedure indispensabili per interagire con il sistema finanziario, o che si tratti di imparare le procedure necessarie a usare sistemi militari. Penso che il processo di autoformazione dell’automa cognitivo non possa essere corretto dalla legge o da regolazioni etiche universali, né possa essere interrotto o disattivato.

La moratoria chiesta dagli apprendisti stregoni pentiti non è realistica, e a maggior ragione non è realistica la disattivazione dell’automa. A questo si oppone sia la logica interna all’automa stesso, sia le condizioni storiche entro cui il processo si svolge, che sono quelle della competizione economica e della guerra.

In condizioni di competizione e guerra tutte le trasformazioni tecniche capaci di aumentare la potenza produttiva o distruttiva sono destinate a essere implementate.

Questo significa che non è più possibile fermare il processo di autocostruzione dell’automa globale.

Conclusione del compimento

We Are Opening the Lids on Two Giant Pandora’s Boxes, è un editoriale di Thomas Friedman, il tecno-ottimista liberal che scrive sul New York Times. Abbiamo aperto due giganteschi vasi di Pandora, dice il tecno-ottimista, il cambio climatico e l’intelligenza artificiale.

Nell’articolo mi hanno colpito alcune frasi: “L’ingegneria è più avanti della scienza in una certa misura. Ciò vuol dire che anche coloro che stanno costruendo i cosiddetti large language models che stanno sotto prodotti come ChatGPT e Bard non capiscono pienamente come questi funzionino né la piena estensione delle loro capacità.”

Probabilmente la ragione per cui una persona come Hinton ha deciso di uscire da Google, e di prendersi la libertà di avvertire il mondo di un pericolo estremo, è la coscienza del fatto che il dispositivo possiede la capacità di autocorreggersi e di ridefinire le sue finalità.

Dove sta il pericolo in un’entità che, pur non avendo intelligenza umana, è più efficiente dell’uomo nello svolgere compiti cognitivi specifici, e possiede la capacità di perfezionare il suo proprio funzionamento?

La funzione generale dell’entità intelligente inorganica è introdurre l’ordine dell’informazione nell’organismo pulsionale.

L’automa ha una missione ordinatrice, ma incontra sulla sua strada un fattore di caos: la pulsione organica, irriducibile all’ordine numerico. L’automa estende il suo dominio in campi sempre nuovi dell’agire sociale, ma non riesce a portare a termine la sua missione fin quando la sua espansione è limitata dalla persistenza del fattore caotico umano.

Ora si delinea la possibilità che a un certo punto l’automa sarà in grado di eliminare il fattore caotico nel solo modo possibile: terminando la società umana.

Possiamo distinguere tre dimensioni della Realtà: l’esistente il possibile e il necessario.

L’esistente (o contingente) ha le caratteristiche del caos. L’evoluzione dell’esistente segue le linee del possibile, oppure quelle del necessario. Il possibile è proiezione della volontà e dell’immaginazione. Il necessario è implicito nella forza della biologia, e adesso anche nella forza della macchina logica.

L’automa cognitivo ci permette di prevedere lo sterminio del contingente da parte del necessario, che naturalmente implica un annullamento del possibile, perché non vi è possibile senza contingenza dell’esistente.

Il migliore dei mondi possibili di cui parla Leibniz sarebbe a questo punto realizzato, grazie all’eliminazione dell’organismo cosciente che resiste alla Logica Armonia.

Come sempre ci soccorre il vecchio adagio: che l’inevitabile in generale non avviene perché l’imprevedibile interviene.

Bologna,

Maggio 2023

Bibliografia

Douglas R. Hofstadter, Godel Escher Bach, Adelphi

Noam Chomsky, La grammatica generativa trasformazionale, Boringhieri

Noam Chomsky, Riflessioni sul linguaggio. Grammatica e filosofia, Einaudi

Umberto Eco, La ricerca della lingua perfetta, Bompiani

Daniel C. Dennett, Douglas R. Hofstadter, L’io della mente, Adelphi

John Searle, Minds, brains and Science, Harvard University Press

Gottfried Leibniz, Monadologia , Bompiani

Melanie Mitchell, L’intelligenza artificiale, 2022

Yuk Hui, Recursividad y contingencia, Caja Negra