Negli ultimi tempi ho sviluppato un’abitudine bizzarra che nasce in uno dei modi più low tech possibili: per posta. Ogni mese ricevo una busta con all’interno la rivista cartacea stampata da Midjourney, l’azienda di San Francisco responsabile dell’IA con lo stesso nome, in grado di generare immagini sulla base di input testuali degli umani. Avevo ordinato il primo numero (4 dollari, spese di spedizione internazionali incluse) convinto che l’esperienza di lettura della rivista mi avrebbe detto qualcosa di particolarmente rivelatore sulla materialità dell’intelligenza artificiale. La cosa è finita per essere sì rivelatrice, ma di altro: l’invio della rivista si rinnova in automatico, ma pare non fermarsi, e questa continua ad arrivare puntuale, ed è diventata la cosa più bullshit della mia vita.

Uso il termine forte della sua ampia accettazione, anche accademica: il filosofo Harry G. Frankfurt – peraltro recentemente e silenziosamente scomparso – nel suo On Bullshit ha fatto del termine un dei più significativi della nostra epoca. Nell’ottica di Frankfurt, la bullshit è più di una bugia: è qualcosa che viene espresso senza alcun riguardo nei confronti della realtà fattuale, senza alcuna preoccupazione in riferimento al vero o al suo contrario. Il bullshitter, in questo senso, non ha alcun interesse a mentire, perché per farlo dovrebbe accettare l’esistenza di una verità da contraddire.

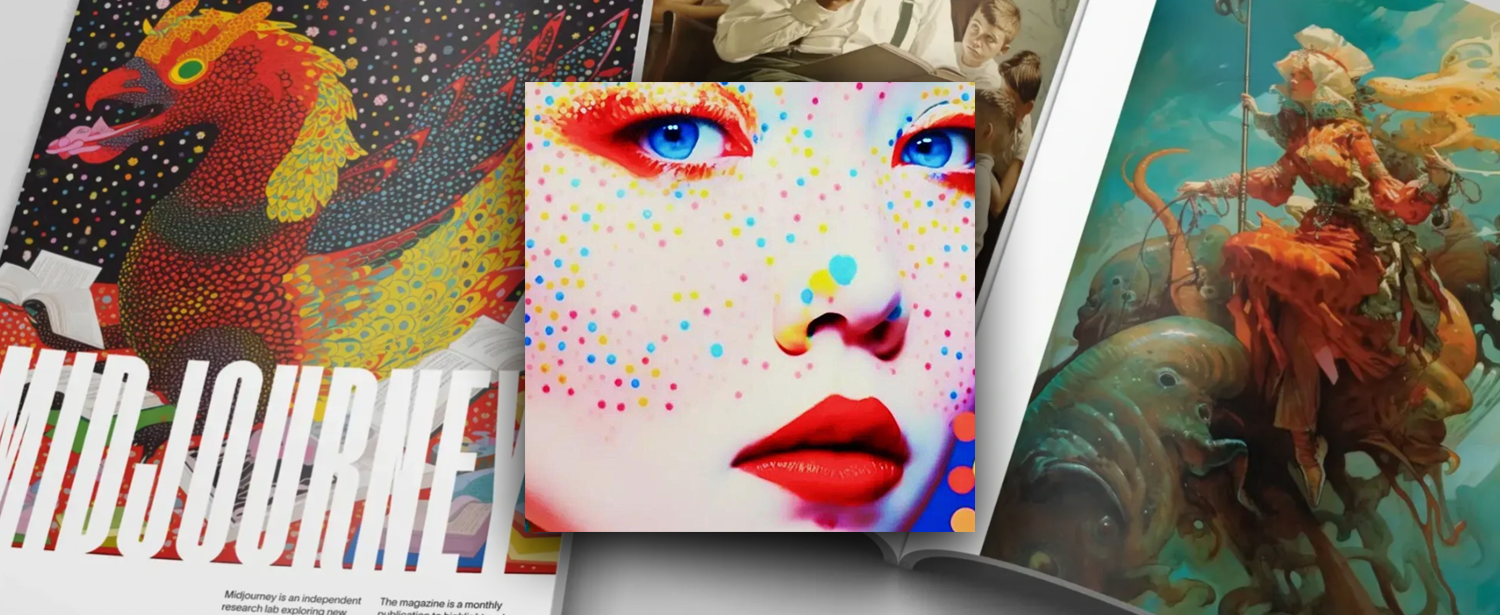

Il bullshitter si muove, invece, su un livello diverso: quello dove il concetto di veridicità non ha alcuna rilevanza e la finzione non è tale perché in contrapposizione con qualcos’altro di vero: è semplice fuffa che imita una realtà che è solo potenzialmente verosimile. Ogni volta che la posta mi restituisce una copia della rivista di Mindjourney torno alle bullshit di Frankfurt. La rivista è di fatto un catalogo delle immagini create dalla “community” (e da chi se no?) che utilizza l’IA per creare immagini, una sorta di best of delle produzioni intervallato da interviste con alcuni creator, per lo più occidentali.

Ci sono immagini di natura molto diversa. Pescando dall’ultimo numero: animali e cibo vanno per la maggiore, come l’immaginario fantasy, quello vagamente Pixar e quello sci-fi ma hyperpop, c’è la pubblicità di un profumo, qualche tentativo retrò o astratto. Senza entrare nel merito del giudizio estetico, che non mi interessa, o su quello dei possibili utilizzi di questi materiali in ambito artistico o altro, sfogliare la rivista di Midjourney rivela comunque cosa sia l’IA generativa oggi: una macchina di bullshit.

le aziende produttrici di questi sistemi continuano a spingere la narrativa per la quale le loro IA arriveranno prima o poi ad avere pensieri propri, creativi e se possibile anche psichedelici

Niente di quello che producono i sistemi di IA generativa, infatti, ha alcuna consapevolezza di sé. Niente di quello che viene generato dalle IA risponde a un qualche criterio di veridicità o di senso. Questo vale per Midjournery come per ChatGPT e gli altri strumenti diventati virali negli ultimi mesi. Nessuno di questi strumenti esiste per creare alcunché di vagamente vero o rispettoso delle volontà degli esseri umani che formulano le richieste alla macchina. Nel loro fornire un output sulla base di un input, queste forme algoritmiche rispondono a un criterio puramente statistico e quantitativo.

ChatGPT non conosce le parole, né il loro significato, né il loro uso umano: sa replicarne al massimo la forma, le occorrenze, la frequenza di utilizzo in contesti umani pregressi. Sa riassemblarle nel modo statisticamente più vicino a quanto farebbe un essere umano per comunicare. Lo stesso vale, anche se con presupposti tecnici diversi, anche per le immagini di Midjourney. Creare qualcosa di verosimile senza avere alcuna percezione del vero, come abbiamo visto, è la definizione quintessenziale di bullshit.

La questione diventa, quindi, capire come relazionarsi a questo stato di cose, ovvero come poter usare generatori di bullshit per scopi diversi. In primis, occorre mettere da parte il panico morale che già sta influenzando il discorso pubblico: non stiamo assistendo alla morte del Vero (quale poi?), né all’imminente fine dell’intelligenza umana, né alla sconfitta dell’umano, né alla resa di fronte alle macchine. Anche questi punti di vista “lungoterministi” sono in larga parte bullshit speculative: pensando di anticiparlo, inventano un problema in uno scenario che non appartiene, al momento, alla realtà e con ogni probabilità mai lo farà.

Leggere il dibattito mainstream attorno alle tecnologie digitali non è tanto diverso da sfogliare la rivista di Midjourney: le famigerate “existential threat” dibattute dai vari Vati dell’IA – quasi sempre maschi, quasi sempre americani, quasi sempre stupidamente ricchi – sono bullshit. ll loro obiettivo non differisce da una campagna marketing il cui scopo è offuscare questioni concrete, come ha scritto la scorsa primavera, in risposta all’ennesima presa di posizione bullshit sui rischi dell’IA, un gruppo di ricercatrici e ricercatori guidato da Timnit Gebru. Parlare di dominio delle macchine, di sterminio, di guerre lanciate da intelligenze artificiali bellicose e vendicative è un ottimo modo per sommergere di bullshit problemi e rischi assolutamente non-bullshit, che stanno già ora rendendo la vita di molte persone ancora più difficile. Mi riferisco, ad esempio, alle persone arrestate per via di algoritmi che replicano il razzismo sistemico; persone sfruttate nel sud globale per fare training degli algoritmi; persone la cui sicurezza sul lavoro e il cui standard di vita dipendono da un algoritmo fallace; persone il cui accesso al welfare può essere compromesso per via delle decisioni di un algoritmo che le discrimina. La lista è sempre più lunga, quanto lunga è anche la lista degli ambiti in cui i sistemi di intelligenza artificiale stanno già trovando applicazione.

Il termine “allucinazione” è stato spesso utilizzato per descrivere i prodotti bizzarri o erronei delle intelligenze artificiali generative. Come ha scritto, tra gli altri, Naomi Klein, il termine è però estremamente problematico: attingendo alla psicologia e al misticismo, le aziende produttrici di questi sistemi continuano a spingere la narrativa per la quale le loro IA arriveranno prima o poi ad avere pensieri propri, creativi e se possibile anche psichedelici. Ovviamente, questo non è vero: quegli outcome erronei o disturbanti sono ben altro. Come ha scritto Klein, a starsi facendo un trip lisergico non sono le macchine, ma i CEO delle aziende e i loro fan che stanno creando quelle macchine, specialmente quando fanno riferimento a scenari potenziali per i quali non vi è alcuna evidenza scientifica.

Come ha scritto il ricercatore della Goldsmiths University Dan McQuillan nel suo libro Reisting AI. An Anti-fascist Approach to Artificial Intelligence, l’intelligenza artificiale, anche la più banale e limitata possibile, opera sempre all’interno del mondo, mentre la retorica “grandiosa e le trame di fantascienza” servono proprio a offuscare un aspetto: gli impatti politici di questa tecnologia emergono “dalla risonanza tra le sue caratteristiche tecniche concrete e le condizioni sociali e politiche che le circondano”. L’IA è politica in ogni suo aspetto e soprattutto per il modo in cui va a toccare la distribuzione del potere nel mondo reale, non nelle visioni escapiste dei leader delle aziende che la stanno sviluppando. Quegli esiti sociali, come scrive ancora McQuillan, sono politicamente reazionari. Se passasse l’idea che vi sia qualcosa di magico, di visionario in quello che queste macchine possono sbagliare, perché prese da stati allucinatori, si contribuirebbe a offuscare i veri problemi, le vere questioni aperte verso cui già ora occorre fare resistenza.

Questo mondo di clickbait, spam, pseudo-contenuti, quasi-truffe e monetizzazione degli spiccioli prodotti dalla nostra scarsa attenzione non aspettava altro che la possibilità di generare ulteriori bullshit nel modo più economico e scalabile possibile

Ricercatrici come Kate Crawford, Meredith Broussard, la già citata Timnit Gebru, Safiya Noble e molte altre hanno negli ultimi anni analizzato e teorizzato le fallibilità dell’intelligenza artificiale e dei sistemi algoritmici. Hanno evidenziato come i documentati output razzisti, sessisti e discriminatori delle IA generative non siano semplici glitch o malfunzionamenti tecnici riparabili, ma segnali e sintomi connessi alle più grandi problematiche sociali extra-tecnologiche che questi strumenti replicano, essendo stati programmati e venendo utilizzati entro la medesima realtà. Solo nella fantascienza, e solo nelle bullshit del pensiero tecnosoluzionista, infatti, la tecnologia è qualcosa di neutro, obiettivo e privo di qualsiasi connotazione politica. Questo vale tanto per le IA progettate esplicitamente per scopi oppressivi, come il riconoscimento facciale, quanto per quelle più leggere, come Midjourney. Questo è un punto da non sottovalutare, perché, anche nel caso delle IA generative, il problema degli errori sistemici può solo essere limitato – o al massimo nascosto – e non risolto.

La questione più importante da affrontare quando si parla del nostro futuro rapporto con le bullshit generate dall’IA sarà in primis venire a patti con il fatto che ne saremo circondati, specialmente negli spazi online. L’industria dell’informazione, in particolare, ricorrerà all’IA generativa, come ha sfruttato al massimo ogni precedente possibile strategia di abbattimento dei costi di produzione. Questo contribuirà direttamente all’accelerazione della decrescita del valore delle notizie online, già in caduta libera con la digitalizzazione. È più che prevedibile anche che vi sarà un’adozione massiva di questi strumenti nel settore della pubblicità online, specialmente in quella che infesta le pagine web già ora con contenuti bullshit per lo più già piazzati in automatico. Questo mondo di clickbait, spam, pseudo-contenuti, quasi-truffe e monetizzazione degli spiccioli prodotti dalla nostra scarsa attenzione non aspettava altro che la possibilità di generare ulteriori bullshit nel modo più economico e scalabile possibile.

Cory Doctorow ha recentemente scritto di enshittification per descrivere come le piattaforme online entrano in crisi, perdono di centralità per i loro utenti, vengono snaturate o finiscono per essere riempite per lo più da contenuti bullshit in vario formato, fino a trasformarsi in meri sili per l’estrazione di dati. E poi morire. Circondati da bullshit, dentro piattaforme sempre più paludose, la nostra esperienza di Internet diventerà progressivamente meno sensata, meno significativa, meno utile. E non per via del fatto di trovarsi in mezzo a una realtà che sarà progressivamente sempre più generata dalle macchine – quello è di per sé affascinante e quanto meno stimolante – ma per il fatto che quella realtà sarà generata da queste macchine che oggi chiamiamo frettolosamente IA: macchine profondamente banali, che al massimo sanno contare velocemente, destinate a fallire, a fare errori e a produrne in scala. Macchine che semplificano e snaturano, che sarà fin troppo facile sfruttare per scopi malevoli. E quelli non sono mai bullshit.