Quali diritti per l’intelligenza artificiale?

Pubblichiamo un estratto dal libro La rivolta delle macchine di Murray Shanahan pubblicato da LUISS University Press, ringraziando l’editore per la disponibilità.

Nel Diciottesimo secolo, alcuni oppositori all’abolizione della schiavitù sostenevano che gli schiavi meritavano meno diritti dei loro proprietari a causa della loro intrinseca inferiorità intellettuale. La più potente controdeduzione a questa convinzione era la testimonianza in prima persona degli ex schiavi, perfettamente in grado di articolare la portata della loro sofferenza, raccontando con chiarezza quanto ricca e piena di significato fosse la propria vita interiore. Entrambe le posizioni davano per scontato il legame tra intelligenza e diritti e supponevano che intelligenza e capacità di soffrire procedessero di pari passo. I cavalli e i cani, secondo questo ragionamento, meriterebbero meno diritti rispetto agli esseri umani a causa del loro minor quoziente intellettivo e della corrispondente minore capacità di soffrire.

L’argomentazione relativa a un’IA di livello umano funziona in modo un po’ diverso perché possiamo comunque immaginare una macchina con un alto livello di intelligenza forte che però non sente niente, alla quale manca la capacità di soffrire. Cioè non avremmo un obbligo morale a trattarla in maniera diversa da come consideriamo, che so, un orologio o un tostapane. Nessuno sta male per un tostapane quando si rompe o se la prende quando brucia il pane. Ora, se un’IA fosse non soltanto simile all’uomo nella sua intelligenza ma anche nel comportamento, allora le persone vedrebbero le cose in modo diverso. La società potrebbe arrivare ad accettare che un’IA di questo tipo sia cosciente, specialmente se il suo cervello fosse conforme a un modello biologico. Si potrebbe quindi argomentare in maniera convincente che questa dovrebbe essere considerata come una persona a tutti gli effetti, attribuendole diritti e doveri, un ragionamento analogo a quello applicato per l’abolizione della schiavitù.

Uno dei diritti umani più importanti, ovviamente, è la libertà stessa, la libertà di fare ciò che si desidera, nella misura in cui questa non provoca danni agli altri. Ma affinché l’IA meriti questo diritto, e anzi, perché l’idea stessa della libertà abbia senso, un’intelligenza artificiale dovrebbe possedere più della sola capacità di sperimentare sentimenti positivi e negativi. In primo luogo, avrebbe bisogno di essere in grado di agire rispetto al mondo. Ciò non implica necessariamente la personificazione, perché l’IA potrebbe farlo controllando vari tipi di attrezzature, senza essere dotata di un corpo fisico. Tuttavia, a un’IA semplicemente parlante la questione della libertà risulterebbe irrilevante. Dovrebbe anche essere autonoma, vale a dire in grado di agire senza intervento umano. E ancora, avrebbe bisogno della capacità di prendere consapevolmente le proprie decisioni, di esercitare la volontà scegliendo tra più alternative prima di agire.

Conferire personalità a una categoria di macchine e attribuire loro, di conseguenza, diritti e responsabilità rappresenterebbe di certo una svolta nella storia umana. Chi non ha mai guardato una notte stellata chiedendosi se siamo soli nell’universo? Ammettere un’IA di livello umano nella comunità di esseri coscienti equivarrebbe a riconoscere che non siamo soli nell’universo, non perché abbiamo scoperto l’intelligenza extraterrestre, ma perché abbiamo generato una nuova forma di coscienza terrestre con un livello di intelligenza uguale al nostro. Alla nostra storia, e alla storia della vita sulla Terra, si unirebbe quella di un altro tipo di essere, con capacità nuove e diverse.

Supponiamo che un’IA commetta un crimine, e che poi venga duplicata. Le responsabilità, così come i diritti, si accompagnano con l’essere persona, ma quale delle due copie deve essere considerata responsabile?

Ad ogni modo, se l’avvento di un’intelligenza artificiale di livello umano pienamente consapevole ci porterà verso un nuovo mondo, il percorso non sarà affatto facile. Molti dei concetti che sostengono la società umana così come la conosciamo sarebbero a rischio. Per esempio, prendiamo in considerazione la proprietà di un bene: il diritto ad avere delle proprietà sarebbe sicuramente uno dei vantaggi della persona artificiale. Supponiamo però che un’IA venga duplicata, in modo da avere due copie attive dell’IA dove prima ne esisteva solo una. Al momento della duplicazione sono identiche, ma da quel momento in poi le storie delle due IA si separano. Magari hanno accesso a dati diversi, o controllano dispositivi diversi (per dire, dei corpi robotici) o interagiscono con persone o sistemi differenti.

A quel punto chi possiede la proprietà appartenente al predecessore, il progenitore delle due copie? Viene semplicemente divisa a metà? O il predecessore può stabilire come la sua proprietà sarà divisa tra i due discendenti? In caso affermativo, cosa succederebbe nel momento in cui le due arrivassero ad avere una controversia? Supponiamo che una delle copie venisse terminata per una ragione qualunque. Le sue proprietà verrebbero trasferite all’altra copia? Il problema è chiaramente analogo a quello di un’eredità, in un certo senso, e al divorzio in un altro. Un quadro giuridico potrebbe anche essere delineato, ma i suoi dettagli sarebbero indubbiamente complessi.

E la proprietà è solo una delle tante sfide che nascono dalla possibilità di duplicazione. Supponiamo che un’IA commetta un crimine, e che poi venga duplicata. Le responsabilità, così come i diritti, si accompagnano con l’essere persona, ma quale delle due copie deve essere considerata responsabile? Dovrebbero esserlo entrambe? Cosa accadrebbe se, trascorso molto tempo, le due copie dovessero divergere in maniera sostanziale? Supponiamo che una delle due confessasse e mostrasse rimorso, e l’altra mentisse e, una volta scoperta, non fosse affatto pentita. Se entrambe venissero ritenute responsabili delle azioni passate del loro comune antenato, dovrebbero essere punite allo stesso modo? O una delle due dovrebbe ricevere una punizione maggiore?

A complicare ulteriormente la faccenda, c’è il fatto che la duplicazione è solo uno dei diversi eventi stravaganti che possono determinare una variazione del numero totale di persone coscienti, nel caso delle intelligenze artificiali. Per gli esseri umani, ci sono solo due eventi di questo tipo: la nascita e la morte. Ma non solo le IA possono essere create, distrutte e duplicate, possono anche essere suddivise o aggregate insieme. Cosa potrebbe significare? Beh, un’IA potrebbe essere divisa in due (o più) varianti, dove ognuna di queste avrebbe una parte dei suoi attributi psicologici, per esempio un sottoinsieme delle sue competenze o dei suoi ambiti d’azione o delle sue fonti di dati in arrivo o dei suoi ricordi. Viceversa, due (o più) IA potrebbero essere fuse in una, seguendo un tipo di procedimento opposto, stavolta combinando insieme competenze, poteri, sensi o ricordi.

L’idea di dividere un insieme di memorie episodiche (i ricordi che una persona ha di certi eventi della propria storia) è meno problematica per un’IA rispetto a quanto possa esserlo per un essere umano. Infatti a differenza di un essere umano, la cui cronologia personale è legata al proprio corpo, un’IA potrebbe essere incorporea o abitare più di un corpo alla volta. Analogamente, potrebbe essere in grado di tenere molte conversazioni allo stesso tempo, o di controllare simultaneamente molti tipi diversi di apparecchiature. Il risultato consisterebbe di molteplici cronologie separabili, ognuna associata a un diverso insieme di corpi, conversazioni, tipi di apparecchiature, ma che appartengono a una sola IA nel senso che sono cognitivamente integrate e regolate da uno scopo comune. Separando queste cronologie come si fa con i fili che compongono un pezzo di corda, da una sola IA se ne potrebbero assemblare tante. Oppure, se ne potrebbe costruire una legandone insieme tante altre.

Sicuramente un’IA dotata di personalità dovrebbe avere il diritto di cittadinanza, di appartenere a uno stato. Ma quale? A differenza di una persona, sarà indubbiamente atipico che un’IA abbia una posizione spaziale ben definita.

Concetti quali la proprietà e la responsabilità, messi in discussione dalla possibilità di duplicazione, entrano ulteriormente in crisi con la possibilità di suddivisione e di fusione. E non sono solo proprietà e responsabilità a risultare problematici come argomenti. Pensiamo all’omicidio, un crimine tra gli esseri umani. Qual è il crimine analogo quando la vittima è un’IA? È un crimine terminare l’esecuzione di tutti i processi che costituiscono l’IA? E se questi processi potessero essere riavviati? Sarebbe un crimine sospendere tutti quei processi e basta? E che dire della duplicazione, della suddivisione o della fusione? Dovrebbe essere considerato un crimine eseguire queste operazioni su un’IA contro la sua volontà? In quali circostanze (se ce ne fossero) un’IA potrebbe essere autorizzata a eseguire tali azioni? A dirla tutta, chi avrebbe mai il diritto in prima istanza di creare intelligenze artificiali, se creare un’IA significa creare una persona artificiale dotata di coscienza e capacità di soffrire? Qualsiasi essere umano potrebbe essere autorizzato a fare una cosa del genere? Come dovrebbe essere regolata la materia? Dovrebbe essere permesso a un’IA di crearne altre?

Le domande sono infinite, e mettono in discussione molto di ciò che la società umana dà per scontato. Pensiamo alla cittadinanza: ci sembra del tutto normale che un essere umano diventi cittadino del paese in cui è nato. Ma come considerare un’IA? Sicuramente un’IA dotata di personalità dovrebbe avere il diritto di cittadinanza, di appartenere a uno stato. Ma quale? A differenza di una persona, sarà indubbiamente atipico che un’IA abbia una posizione spaziale ben definita. Anche se avesse un corpo singolo con delimitazioni chiare, il suo software potrebbe essere in esecuzione su un qualsiasi numero di computer distribuiti, situati fisicamente ovunque nel mondo. Forse un’IA potrebbe ereditare la cittadinanza dal suo proprietario. Ma abbiamo visto che l’idea stessa di possedere un’IA cosciente è moralmente discutibile.

Supponiamo che la questione della cittadinanza possa essere in qualche modo risolta (potrebbe anche essere risolta in modi diversi da nazioni diverse). Se un’IA finisse con il trovarsi in una democrazia, allora avrebbe presumibilmente diritto a votare. Eppure anche nelle democrazie più illuminate non tutti i cittadini hanno il diritto di votare. Nel Regno Unito, così come in tante altre nazioni, gli elettori devono avere almeno 18 anni. Tutte le IA considerate consapevoli e dotate di intelligenza di livello umano dovrebbero avere diritto al voto, o dovrebbero esserci ulteriori requisiti di idoneità? E come funzionerebbe in questo contesto la questione della moltiplicazione? Sarebbe ovviamente inaccettabile se un’IA si duplicasse migliaia di volte per ottenere mille voti in più, magari per finire col distruggere le proprie copie alla fine della votazione.

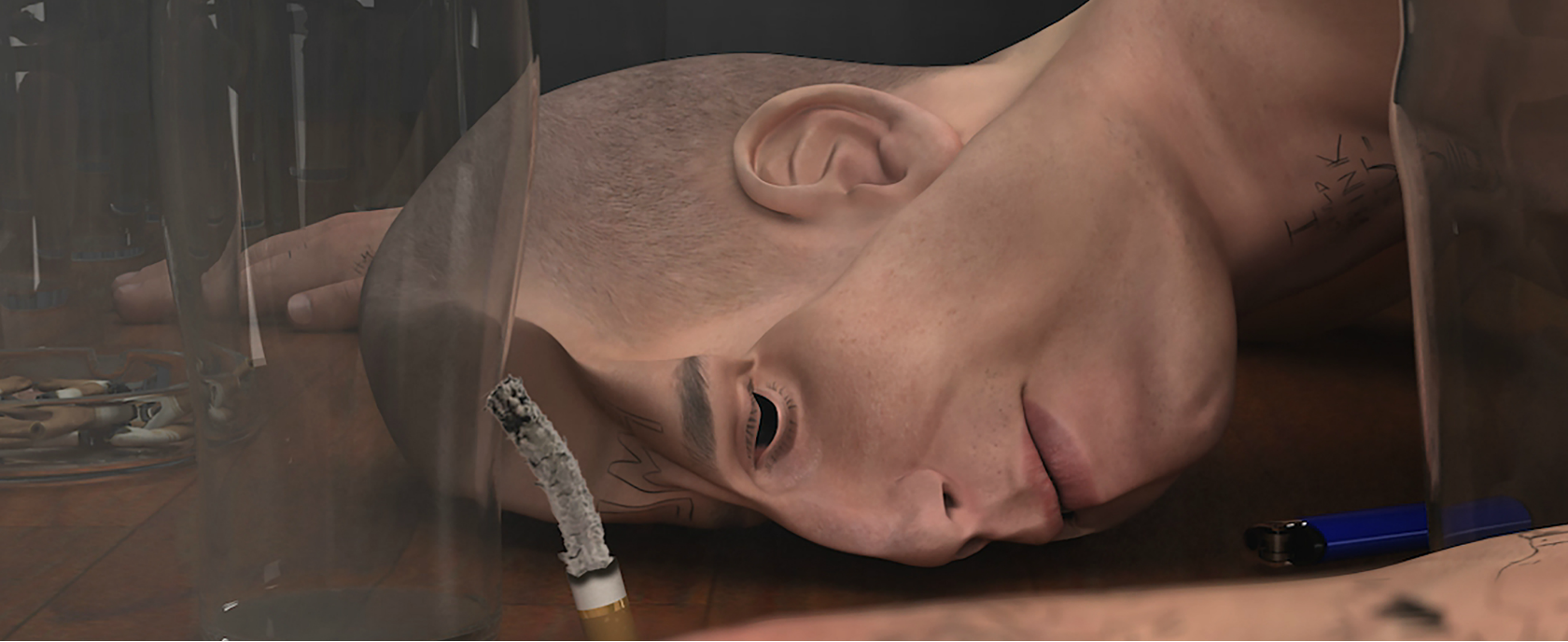

Ed Atkins – Us Dead Talk Love

La precedente sezione ha sollevato più domande di quante ne abbia risolte, poiché ognuna di queste meriterebbe un ampio dibattito a parte. Tuttavia il messaggio chiave è semplice: se creiamo una forma di intelligenza artificiale di livello umano che è considerata come un essere cosciente e quindi meritevole di diritti e responsabilità, allora molte delle nostre istituzioni più importanti – finanziarie, giuridiche e politiche – dovranno essere rivoluzionate, nel bene o nel male. Anche se le IA in questione fossero amichevoli (cosa niente affatto scontata), il processo sarà probabilmente traumatico. Ci sono alte probabilità che il tutto provochi dissenso, agitazioni o conflitti.

La prospettiva di un’IA cosciente di livello umano turba parecchio, ma le implicazioni legate a una superintelligenza cosciente sarebbero ancora maggiori. Per prima cosa, le argomentazioni a favore dei diritti e delle responsabilità della superintelligenza delle macchine sarebbero uguali a quelli per l’IA di livello umano. Se cosciente, se in grado di sperimentare sofferenza e gioia (o almeno uno stato di soddisfazione), una superintelligenza artificiale meriterebbe sicuramente gli stessi diritti di un essere umano. O meglio, meriterebbe almeno gli stessi diritti di un essere umano; si potrebbe infatti ritenere che una superintelligenza cosciente ne avrebbe addirittura più diritto rispetto a un normale essere umano.

Molte persone sarebbero disposte a sacrificare la vita di un gatto per salvarne una umana. Un essere umano (potrebbe essere questo il ragionamento) ha una maggiore capacità di sofferenza e di gioia rispetto a un gatto, in parte grazie alla capacità tutta umana di riflettere in maniera cosciente su quegli stessi sentimenti, non solo nel momento in cui li prova ma anche quando li ricorda o quando prevede di provarli. Quindi il gatto sarebbe spacciato. Ma cosa succederebbe se la scelta fosse tra la vita di un essere umano e il perdurare di una superintelligenza? Un’argomentazione analoga potrebbe portare la superintelligenza al vertice della scala? Il suo intelletto ben al di là di quello umano implicherebbe forse una capacità sovrumana a soffrire e gioire, implicando che dovrebbe essere l’uomo ad avere la peggio?

L’approccio transumanista per stare al passo con la superintelligenza non è semplicemente quello di utilizzare la tecnologia, ma di diventare un tutt’uno con essa.

Le stesse scottanti domande possono essere fatte nell’ambito del transumanesimo. I transumanisti sostengono l’uso della tecnologia per trascendere i limiti biologici del corpo umano e del suo cervello. L’intelligenza umana potrebbe essere migliorata in diversi modi, in senso farmaceutico, genetico o con l’uso di protesi. I progressi nel campo medico hanno il potenziale per far sparire le malattie e arrestare il processo di invecchiamento, aumentando così la durata della vita umana a tempo indeterminato. In modo ancora più radicale, la tecnologia dell’emulazione cerebrale potrebbe (probabilmente) essere utilizzata per caricare la mente di una persona in un substrato computazionale allo scopo di renderla invulnerabile alla malattia o al decadimento in maniera permanente.

Le questioni indicate dal transumanesimo e le domande sollevate dalla prospettiva di una superintelligenza artificiale sono strettamente correlate. Per cominciare, un modo in cui gli uomini potrebbero rispondere alla prospettiva di macchine superintelligenti, sia che le ammirino sia che le temano, è quello di cercare di «tenere il passo», ovvero di aumentare continuamente l’intelligenza umana in modo che corrisponda sempre all’intelligenza artificiale migliore disponibile.

Come già accennato, l’intelligenza di ogni individuo, anche se non specializzato, sarà un modello unico fatto di punti di forza e di debolezza. Un buon team di lavoro spesso è composto da persone con competenze complementari. Allo stesso modo un gruppo di IA potrebbe dotarsi di diversi sistemi distinti, ciascuno con intelligenza forte, ma ognuno con la propria specialità. Nella stessa ottica, possiamo immaginare team ibridi che comprendano sia esseri umani che IA. A tutti gli effetti, queste combinazioni uomo-macchina sono diventate i migliori giocatori di scacchi del mondo alla metà degli anni Duemila, superando i migliori uomini e i migliori computer grazie alla combinazione del supporto tattico del computer con la guida strategica umana.

Per questo motivo, un approccio per stare al passo della superintelligenza delle macchine potrebbe essere semplicemente quello di impiegare una sofisticata tecnologia IA come strumento, amplificando l’intelligenza umana in maniera non invasiva, per così dire. In buona sostanza, questo è ciò che gli esseri umani hanno fatto fin dall’invenzione della scrittura, ma i transumanisti mirano ad ancora di più. L’approccio transumanista per stare al passo con la superintelligenza non è semplicemente quello di utilizzare la tecnologia, ma di diventare un tutt’uno con essa. Nessuno che utilizza un calcolatore dice che lo sente come una parte della propria mente nello stesso modo in cui chi è bravissimo con uno strumento come un pennello direbbe invece che lo considera una parte del corpo. Il funzionamento interno di una calcolatrice rimane nascosto all’utente, che dunque prende i suoi risultati semplicemente come un dato di fatto. Abbiamo un approccio molto più intimo, seppur imperfetto, con i processi intellettuali che si svolgono nelle nostre teste, e questa intimità facilita la riflessione e l’integrazione cognitiva.

Una prospettiva sul potenziamento cognitivo che sia corretta secondo i transumanisti richiede lo stesso livello di intimità. L’uomo migliorato non sarebbe né un utilizzatore della tecnologia IA né un membro di un team computerumano. Piuttosto, interfacciata direttamente al suo cervello, quella sofisticata tecnologia IA diventerebbe parte della sua mente, consentendo un accesso non mediato ai suoi processi computazionali. Il risultato sarebbe un nuovo tipo di essere umano, una specie ibrida bio-macchina con abilità potenzialmente molto più vaste di quelle di una persona ordinaria. Il resto della società dovrebbe allora decidere come trattare quegli individui, mentre a loro volta quelli dovrebbero decidere come trattare noi.